[ad_1]

Já vivemos em um mundo onde assistentes virtuais podem ter uma conversa contínua (e até sedutora) com as pessoas. Mas o assistente virtual da Apple, Siri, tem dificuldades com alguns aspectos básicos.

Por exemplo, perguntei ao Siri quando acontecerão as Olimpíadas deste ano, e ele rapidamente revelou as datas corretas para os jogos de verão. Mas quando continuei com “Adicione ao meu calendário”, o assistente virtual respondeu de forma imperfeita com “Como devo chamá-lo?” A resposta a essa pergunta seria óbvia para nós, humanos. O assistente virtual da Apple foi perdido. Mesmo quando respondi: “Jogos Olímpicos”, Siri respondeu: “Para quando devo agendar?”

O Siri tende a vacilar, pois carece de consciência contextual, o que limita sua capacidade de acompanhar uma conversa como um ser humano faz. Isso pode mudar já em 10 de junho, o primeiro dia da Conferência Mundial de Desenvolvedores (WWDC) anual da Apple. Espera-se que a fabricante do iPhone revele atualizações importantes em seu próximo sistema operacional móvel, provavelmente chamado iOS 18, com mudanças significativas supostamente reservadas para a Siri.

O assistente virtual da Apple causou sensação quando estreou com o iPhone 4S em 2011. Pela primeira vez, as pessoas puderam falar com seus telefones e receber uma resposta humana. Alguns telefones Android ofereciam pesquisa e ações de voz básicas antes do Siri, mas eram mais baseados em comandos e amplamente considerados menos intuitivos.

Siri representou um salto em frente na interação baseada em voz e lançou as bases para assistentes de voz subsequentes, como Alexa da Amazon, Assistente do Google e até mesmo ChatGPT da OpenAI e chatbots Gemini do Google.

Deixe de lado o Siri, os assistentes multimodais estão aqui

Embora a Siri tenha impressionado as pessoas com sua experiência baseada em voz em 2011, seus recursos são visto por alguns como ficando atrás dos seus pares. Alexa e Google Assistant são especialistas em compreender e responder perguntas, e ambos se expandiram para casas inteligentes de maneiras diferentes da Siri. Parece que a Siri não atingiu todo o seu potencial – embora seus rivais tenham recebido críticas semelhantes.

Em 2024, a Siri também enfrenta um cenário competitivo dramaticamente diferente, que foi sobrecarregado pela IA generativa. Nas últimas semanas, OpenAI, Google e Microsoft revelaram uma nova onda de assistentes virtuais futuristas com capacidades multimodais, que representam uma ameaça competitiva para a Siri. De acordo com o professor da NYU, Scott Galloway, em um episódio recente de seu podcastesses chatbots atualizados estão prestes a ser os “assassinos de Alexa e Siri”.

Scarlett Johannson e Joquin Phoenix compareceram à estreia dela em um festival de cinema em 2013. Avançando para 2024, Johannson acusou a OpenAI de replicar sua voz para seu chatbot sem sua permissão.

No início deste mês, a OpenAI revelou seu mais recente modelo de IA. O anúncio ressaltou o quão longe os assistentes virtuais chegaram. Em sua demonstração em São Francisco, a OpenAI mostrou como o GPT-4o poderia manter conversas bidirecionais de maneiras ainda mais humanas, com a capacidade de flexionar o tom, fazer comentários sarcásticos, falar em sussurros e até mesmo flertar. A tecnologia demonstrada rapidamente atraiu comparações com a personagem de Scarlett Johansson no Drama de Hollywood de 2013, Ela, em que um escritor solitário se apaixona por sua assistente virtual de voz feminina, dublada por Johansson. Após a demonstração do GPT-4o, o ator americano acusou a OpenAI de criar uma voz de assistente virtual que soava “assustadoramente semelhante” à dela, sem sua permissão. A Open AI disse que a voz nunca foi feita para se parecer com a de Johansson.

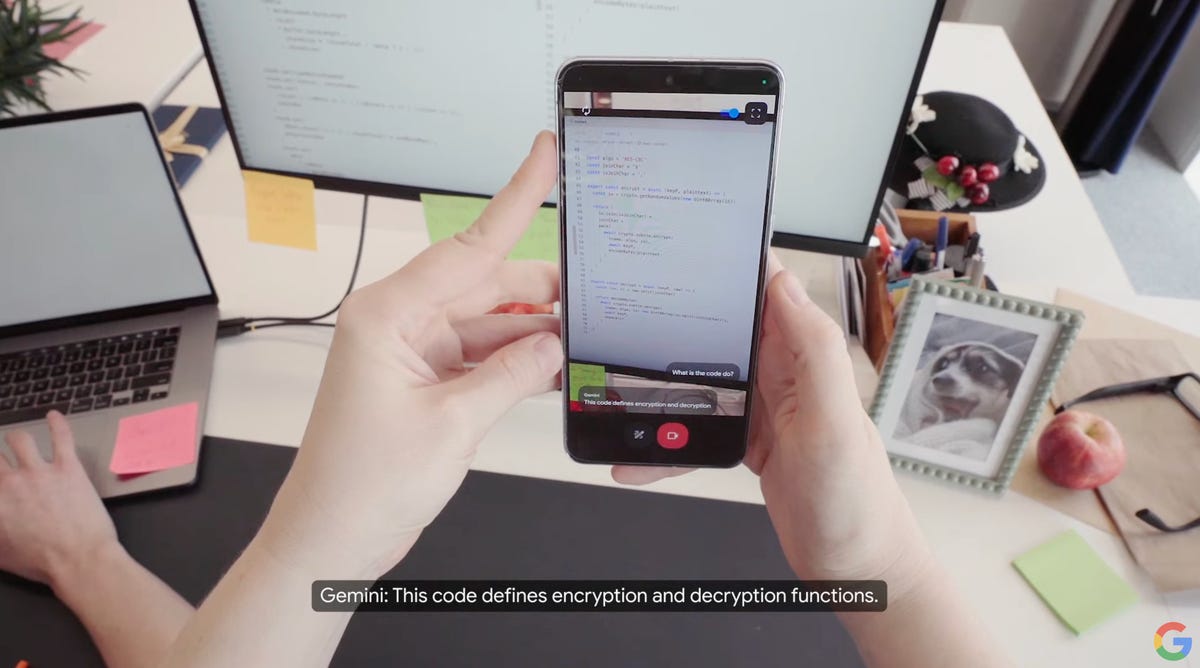

A controvérsia aparentemente ofuscou alguns recursos do GPT-4o, como seus recursos multimodais nativos, o que significa que o modelo de IA pode compreender e responder a entradas além do texto, abrangendo imagens, linguagem falada e até vídeo. Na prática, o GPT-4o pode conversar com você sobre uma foto que você mostra (carregando mídia), descrever o que está acontecendo em um videoclipe e discutir uma notícia.

consulte Mais informação: Scarlett Johansson “irritada” com o chatbot da OpenAI imitando a voz de ‘dela’

No dia seguinte à prévia do OpenAI, o Google exibiu sua própria demonstração multimodal, revelando o Projeto Astra – um protótipo que a empresa classificou como o “futuro dos assistentes de IA”. Em um vídeo de demonstração, o Google detalhou como os usuários podem mostrar ao assistente virtual do Google o que está ao seu redor usando a câmera do smartphone e, em seguida, discutir os objetos em seu ambiente. Por exemplo, a pessoa que interagiu com a Astra no que provavelmente era o escritório do Google em Londres pediu ao assistente virtual do Google para identificar um objeto que emitisse um som na sala. Em resposta, Astra apontou o palestrante sentado em uma mesa.

O Google demonstrou o Astra em um telefone e também em óculos com câmera.

O protótipo Astra do Google pode não apenas entender o que está ao seu redor, mas também lembrar detalhes. Quando o narrador perguntou onde eles deixaram os óculos, Astra foi capaz de dizer onde foram vistos pela última vez, respondendo: “No canto da mesa ao lado de uma maçã vermelha”.

A corrida para criar assistentes virtuais chamativos não termina com OpenAI e Google. A empresa de IA de Elon Musk, xAI, está progredindo na transformação de seu chatbot Grok em um com recursos multimodais, de acordo com documentos públicos do desenvolvedor. Em maio, a Amazon disse que estava trabalhando para dar ao Alexa, seu assistente virtual de décadas, uma atualização generativa de IA.

A Siri se tornará multimodal?

Os chatbots conversacionais multimodais representam atualmente a vanguarda para assistentes de IA, oferecendo potencialmente uma janela para o futuro de como navegaremos em nossos telefones e outros dispositivos.

A Apple ainda não possui um assistente digital com recursos multimodais, o que a deixa atrás da curva. A fabricante do iPhone publicou pesquisas sobre o assunto. Em outubro, discutiu Furão, um modelo de IA multimodal que pode entender o que está acontecendo na tela do seu telefone e executar uma série de tarefas com base no que vê. No papel, os pesquisadores exploram como o Ferret pode identificar e relatar o que você está vendo e ajudá-lo a navegar pelos aplicativos, entre outros recursos. A pesquisa aponta para um possível futuro em que a forma como usamos nossos iPhones e outros dispositivos mude completamente.

A Apple está explorando a funcionalidade de um assistente de IA multimodal chamado Ferret. Neste exemplo, o assistente é mostrado ajudando um usuário a navegar em um aplicativo, com Ferret realizando tarefas básicas e avançadas, como descrever detalhadamente uma tela.

Onde a Apple poderia se destacar é em termos de privacidade. A fabricante do iPhone há muito defende a privacidade como um valor fundamental ao projetar produtos e serviços, e irá cobrar a nova versão do Siri como uma alternativa mais privada aos seus concorrentes. de acordo com O jornal New York Times. Espera-se que a Apple atinja essa meta de privacidade processando as solicitações da Siri no dispositivo e recorrendo à nuvem para tarefas mais complexas, mas elas serão processadas em data centers com chips fabricados pela Apple, de acordo com um Wall Street Journal. relatório.

Quanto ao chatbot, a Apple está perto de finalizar um acordo com a OpenAI para potencialmente trazer o ChatGPT para o iPhone, de acordo com Bloomberg, em uma possível indicação de que a Siri não competirá diretamente com ChatGPT ou Gemini. Em vez de fazer coisas como escrever poesia, o Siri se concentrará nas tarefas que já pode realizar e melhorará nelas. de acordo com O jornal New York Times.

Como parte de uma demonstração da WWDC 2012, Scott Forstall, vice-presidente sênior de software iOS da Apple, pediu à Siri que procurasse a média de rebatidas de um jogador de beisebol.

Como o Siri mudará? Todos os olhos voltados para a WWDC da Apple

Tradicionalmente, a Apple tem sido intencionalmente lenta em chegar ao mercado, preferindo adotar uma abordagem de esperar para ver em relação à tecnologia emergente. Esta estratégia funcionou muitas vezes, mas nem sempre. Por exemplo, o iPad não foi o primeiro tablet, mas para muitos, incluindo os editores da CNET, é o melhor tablet. Por outro lado, o alto-falante inteligente HomePod da Apple chegou ao mercado vários anos depois do Amazon Echo e do Google Home, mas nunca alcançou a participação de mercado de seus rivais. Um exemplo mais recente do lado do hardware são os telefones dobráveis. A Apple é o único grande obstáculo. Todos os grandes rivais – Google, Samsung, Honor, Huawei e até empresas menos conhecidas como a Phantom – venceram a Apple.

Historicamente, a Apple adotou a abordagem de atualizar o Siri em intervalos, diz Avi Greengart, analista-chefe da Techsponential.

“A Apple sempre foi mais programática em relação à Siri do que a Amazon, o Google ou mesmo a Samsung”, disse Greengart. A Apple parece agregar conhecimento à Siri aos montes – esportes em um ano, entretenimento no outro.”

Com a Siri, espera-se que a Apple tente se atualizar em vez de abrir novos caminhos este ano. Ainda assim, a Siri provavelmente será o foco principal do próximo sistema operacional da Apple, iOS 18, que supostamente trará novos recursos de IA. Espera-se que a Apple mostre mais integrações de IA em aplicativos e recursos existentes, incluindo Notas, emojis, edição de fotos, mensagens e e-mails, de acordo com Bloomberg.

A Siri pode responder perguntas relacionadas à saúde no Apple Watch Series 9 e Ultra 2.

Quanto ao Siri, espera-se que ele evolua para um ajudante digital mais inteligente este ano. A Apple está treinando seu assistente de voz em grandes modelos de linguagem para melhorar sua capacidade de responder perguntas com mais precisão e sofisticação. de acordo com a edição de outubro do boletim informativo Bloomberg de Mark Gurman, Power On.

A integração de grandes modelos de linguagem, bem como a tecnologia por trás do ChatGPT, está preparada para transformar o Siri em um assistente virtual poderoso e mais sensível ao contexto. Isso permitiria que a Siri entendesse questões mais complexas e com mais nuances e também fornecesse respostas precisas. Espera-se também que a linha do iPhone 16 deste ano venha com maior memória para suportar novos recursos Siri, de acordo com O jornal New York Times.

Consulte Mais informação: O que é um LLM e como ele se relaciona com os AI Chatbots?

“Minha esperança é que a Apple possa usar IA generativa para dar ao Siri a capacidade de se sentir mais como um assistente atencioso que entende o que você está tentando perguntar, mas usa sistemas baseados em dados para respostas vinculadas a dados”, disse Greengart da Techsponential à CNET.

A Siri também poderia melhorar a execução de tarefas em várias etapas. Um setembro relatório da The Information detalhou como o Siri pode responder a comandos de voz simples para tarefas mais complexas, como transformar um conjunto de fotos em um GIF e depois enviá-lo para um de seus contatos. Isso seria um avanço significativo nas capacidades do Siri.

“A Apple também define como os aplicativos do iPhone funcionam, por isso tem a capacidade de permitir que o Siri funcione em todos os aplicativos com a permissão do desenvolvedor – potencialmente abrindo novos recursos para um Siri mais inteligente realizar tarefas em seu nome com segurança”, disse Greengart.

Vê isto: A IA da Apple na WWDC terá uma reviravolta diferente

17 recursos ocultos do iOS 17 que você definitivamente deve conhecer

Ver todas as fotos

Nota do editor: A CNET usou um mecanismo de IA para ajudar a criar várias dezenas de histórias, que são rotuladas de acordo. A nota que você está lendo está anexada a artigos que tratam substancialmente do tópico de IA, mas são criados inteiramente por nossos editores e escritores especializados. Para mais, veja nosso Política de IA.

[ad_2]

Source link